硬件-NvLink

date

icon

password

Sub-item

Blocked by

Parent item

type

status

slug

summary

tags

category

Blocking

服务器分类

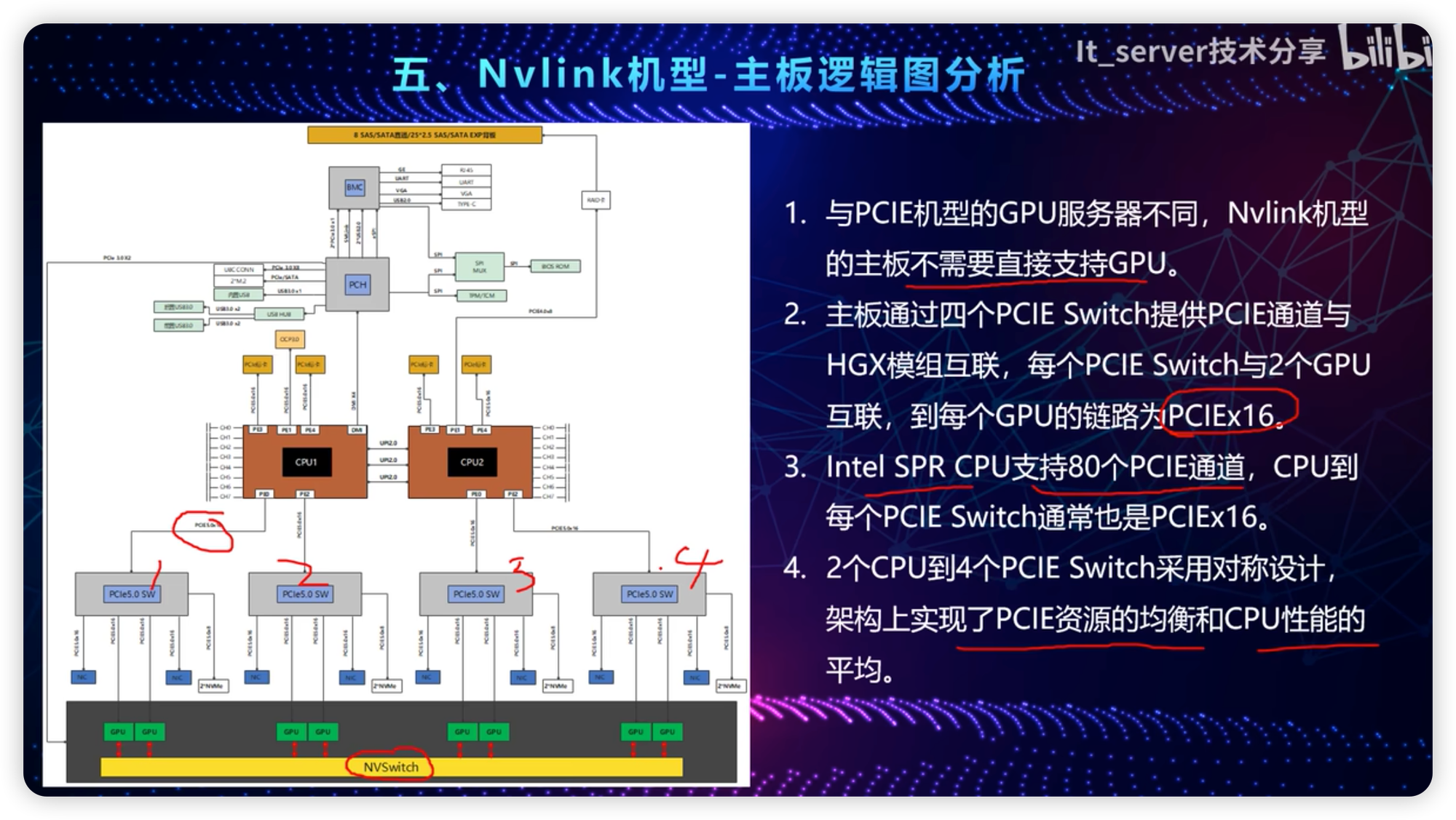

GPU服务器按照GPU芯片之间的互联方式可分为两类:

PCIE机型:

常规的服务器,GPU直接通过PCIE链路进行通信,受限于PCIE的带宽上限,卡与卡双向互联带宽低,不满足大模型训练需求。

Nvlink机型:

也习惯叫SXM机型,指的是在服务器内部,GPU卡之间通过Nvlink链路互联,相比PCIE带宽更高,更适合于大模型训练场景。

类型 | GPU | 通道数 | 双向互联带宽 |

PCIE互联 | A100 | PCIE 4.0 x16 | 2GBx16x2=64GB/s |

PCIE互联 | H100 | PCIE 5.0 x16 | 4GBx16x2=128GB/s |

NVLink互联 | A100 | 每个GPU链路Nvlink x12 | 25GB*12*2=600GB/s |

NVLink互联 | H100 | 每个GPU链路Nvlink x12 | 25GB*18*2=900GB/s |

cpu通过PCIE链接GPU VS GPU通过NvLink直接互联